SharkAvong 1.0 est enfin disponible!

Nous étions nombreux à attendre la sortie de la version 1 avec impatience. Les développeurs qui passaient sur le forum laissaient sous entendre que la sortie se ferait avant la fin du mois, et ils ont tenu parole! SharkAvong 1.0 est arrivé!

Au menu, beaucoup de nouveautés, dont certaines attendues depuis longtemps. Jugez plutôt:

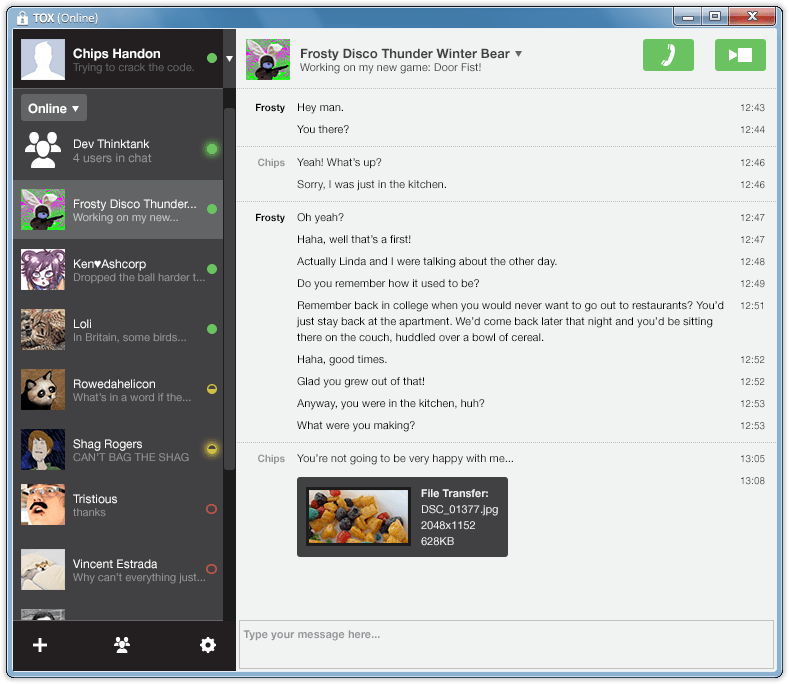

- support de l’internationalisation. L’anglais et le brésilien sont déjà disponibles, le français est en cours.

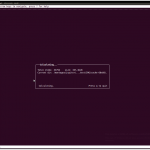

- splash screen à l’ouverture du logiciel, avec indication du statut!

- binaires disponibles pour les plus grandes distributions (Ubuntu)!

- nouveau thème de couleurs, nouveau thème d’icones par défaut

- application skinnable (même si les skins ne sont pas encore disponibles)

- génération d’un fichier de log dès le lancement, facilitant la recherche de bugs

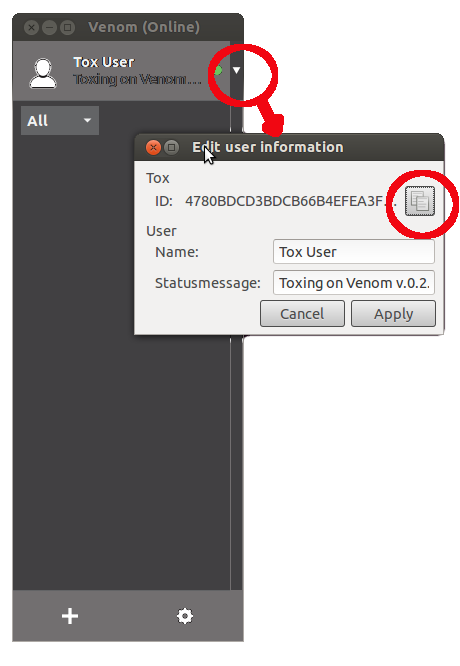

- on peut à tout moment accéder à la fenêtre d’identification (enfin!)

- les derniers éléments non GPL ont été supprimés!

- Installable sur Windows XP!!! (même si ça reste en beta) Bientôt sur Seven(W7)!

- et beaucoup d’autres bugs éliminés!

La mise à jour vous sera proposée au lancement du logiciel, et je vous invite à la suivre de façon automatique, tout s’est très bien déroulé pour moi.

De qui se moque t-on?

Là, toute de suite? De vous. Et c’est moi qui me moque.

SharkAvong n’existe pas. Enfin, pas sous ce nom. Inutile de le chercher sur google, vous ne le trouverez pas au détail. Je me suis bien assuré de n’égratigner personne.

Mais j’en ai eu marre!

Marre des nouvelles qui n’annoncent rien, des infos qui n’en sont pas, des pseudo-journalistes qui ne sont ni journalistes, ni même approchants d’un pseudo quelque chose.

Marre de lire des articles dont le seul but est d’employer des mots clefs destinés à faire augmenter le nombre de visiteurs (malheureusement, ça fonctionne…).

Marre des blogs sur lesquels il faut s’enregistrer pour un commentaire demandant des éclaircissements.

Marre des articles « d’actualité » non datés qui datent de plusieurs années en arrière.

Marre des fanatiques du libre qui font du bruit pensant faire de la publicité.

Parce qu’il est là, le problème.

Revenons au début (traveling arrière, camera zoom avant): le pseudo article que vous avez lu au dessus est une copie d’un article que j’ai lu sur le net. Copie à l’identique ((exception faite des fautes de grammaire et d’orthographe que je ne peux me résoudre à laisser dans un de mes textes)), aux liens près. Bien qu’il n’y en ait aucun…

Or, que dit cet article? Qu’avez vous appris à sa lecture?

Rien. Ni à quoi sert le logiciel, ni où le trouver, ni l’emplacement de la communauté… Rien.

Toujours est il que cet « article », et toutes les copies presque à l’identique repris sur tous les autres blog remplissent les moteurs de recherche de bruit, masquant plus ou moins fortement le site réel du logiciel qui se trouve relégué à la 38e page de google.

Et des articles comme ça, il en apparait tous les jours.

De l’éthique et des liens

Lorsqu’on écrit un article, il faut réfléchir un peu!

Voici 10 préceptes que j’applique avant de cliquer sur « publier »:

- Qui va me lire ? Seulement les gens qui connaissent mon blog ? Non! Les moteurs de recherche amènent autant, voire plus, de lecteurs.

- L’article s’adresse t-il aux initiés, ou aux néophites ? Dans tous les cas, un minimum d’explication est nécessaire, ne serait ce que pour savoir de quoi on parle. Inutile de faire un pédigrée complet à chaque fois, mais une phrase aide à centrer le sujet. L’article complet est il compréhensible?

- Pourquoi j’écris cet article? Si c’est pour ramener des gens à la communauté, il est nécessaire de leur permettre de rejoindre rapidement ladite communauté. Un lien vers le site du projet, ou vers une page qui en parle plus longuement est un minimum pour que l’article serve à quelque chose.

- Cet article est il important/nécessaire? Si l’information que vous diffusez est présente partout sur le net, pourquoi en faire un article? Si vous ne faites que reprendre ce qui existe ailleurs, liez l’article externe à votre blog, au lieu de dupliquer l’information.

- L’article est il juste/pertinent? Avez vous au moins vérifié vous même la véracité des informations? Vous n’imaginez pas le nombre de co***eries ((nn ;o) )) recopiées d’un blog à l’autre dans une course à la primeur de diffusion…

- L’article est il suffisamment commenté/documenté? Un minimum de recherche et de liens dans votre article permet au visiteur de trouver ce qu’il cherche, les réponses à ses questions, et augmente votre crédibilité. Et par conséquent, le fait de rester ou revenir sur votre blog. Sinon, il suffit de regarder combien de visiteurs partent de votre site en moins d’une minute. Une centralisation dans votre article des liens nécessaires permet de faire revenir les visiteurs qui sauront qu’ils n’ont pas à chercher ailleurs ce qu’ils ont trouvé chez vous.

- Cet article est il nécessaire d’une manière ou d’une autre? ((Excepté pour le plaisir de publier sur son blog, bien sûr)) Si je ne le publie pas, va t-il manquer? Si je le publie, que va t-il apporter aux lecteurs? Si je me fais le porte parole d’une communauté, le fais-je bien?

- L’article est il mûr? Vais-je le modifier après publication? ((la réponse est toujours non, mais dans les faits…)) Souvent, après être passé à autre chose, l’esprit se détend et on voit qu’on aurait pu formuler les choses autrement, apporter plus de précisions ou d’indications. Ne publiez jamais après avoir fini la rédaction d’un article. Laissez passer un peu de temps. Pourquoi? Les agrégateurs ne prennent en compte que la première version publiée, et vos modifications ne seront jamais vues si on ne vient pas sur le site. Et si l’article est flou, imprécis, pas intéressant, comme mon exemple du début, on ne viendra jamais sur votre site.

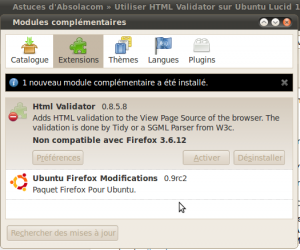

- Me suis-je relu suffisamment? Les fautes de grammaire et d’orthographe sont pénibles à lire, changent le sens des phrases, et surtout, diminuent votre page rank dans les moteurs de recherche! Il existe plein d’outils (à commencer par les navigateurs eux même) qui signalent vos fautes et des sites vous permettant de conjuguer correctement, sans compter Verbiste disponible dans votre distribution. On peut pardonner quelques fautes, mais s’il faut déchiffrer votre écriture, on passe vite au site suivant de google. ((Chromium m’a même proposé la traduction en français d’un site entièrement écrit en français (et bien paramétré au niveau du serveur et des entêtes) mais dont tous les termes étaient mal écrits, en phonétique, cowboyz ou avec des fautes…))

- Ais-je été correct dans mes propos? L’article n’est il pas violent, agressif, malpoli ? L’ai-je écrit sous le coup de l’excitation, la colère ?Pourrais-je un jour le regretter devant mes parents, mes enfants, un employeur, une administration? Liberté d’expression, OK, mais respect des libertés, surtout.

Ce ne sont que les questions principales à se poser lorsqu’on écrit un article. Bien sûr que vous savez de quoi vous parlez, mais si vous êtes le seul, à quoi bon parler?

J’ai plein d’articles dans mes brouillons qui n’ont pas été publiés parce qu’ils ne répondaient pas aux questions ci dessus. un peu de temps suffirait à les rendre éligibles, mais le temps ou l’envie me manquent. Ce n’est pas grave, la qualité générale ne baisse ainsi pas.

Logiciels libres, expression libre

Libriste, c’est bien. Intégriste, même libriste, non.

Mais pour autant, doit on laisser dire n’importe quoi?

Il est vrai que l’assimilation Ubuntu <-> Linux est souvent désagréable, mais cela a ses raisons.

Ubuntu a réussi à fédérer une large part des utilisateurs de Linux ((Je rappelle qu’on doit dire GNU/Linux, mais que dans un soucis répondre à la question 2, je simplifierais en Linux)) pour une raison simple: la simplicité d’utilisation. Ce qui a amené un grande communauté, qui rameute largement à tous les niveaux et qui fait beaucoup de bruit.

Du coup, cela laisse penser que les autres distributions sont minoritaires et négligeables.

La faute à qui?

A tous ces blogs qui n’expliquent pas correctement la distribution dont ils parlent? A ces auteurs qui font savoir qu’ils savent mais ne transmettent pas ce savoir? Aux communautés qui n’assurent un soutien que lorsqu’on parle déjà leur langage? Au manque de documentation compensé par les forums des utilisateurs dont les propos sont 1kompéansib ? A l’assistance RTFM ?

J’ai lu un jour qu’ « une communauté à les utilisateur et le soutien qu’elle mérite« . J’ai été révolté sur le coup, ce qui fait que la phrase m’a marqué. Mais je ne suis pas loin de le penser aujourd’hui. Depuis que je consulte le planet-libre, et que j’y suis publié, je pense en effet qu’une diversité, si elle est rafraichissante et puissante, ne peut être utile que si elle est guidée et canalisée.

Les distributions les plus importantes aujourd’hui sont toutes dirigées/contrôlées/organisées par un comité directeur qui ne fait pas que du développement mais aussi de l’administration et de la modération de forum, ce qui permet d’indiquer la direction à suivre.

Et quand un de mes articles est refusé à la publication (sur le net ou en papier), c’est parce que j’ai raté le coche, pas parce que ces $*µ£% d’admins sont des intégristes bornés équipé d’œillères. Le bien de tous, et la survie de la communauté passe parfois par le désagrément de quelques uns.

Espoir, quand tu nous tiens

Internet commence a rassembler plus de fausses informations que de vraies, en particulier sur les logiciels libres. Les communautés devraient être plus attentives à ce qu’on dit d’elles, et pas attendre que ça vienne tout seul. Et contacter les auteurs pour leur faire corriger les fausses informations, rumeurs et manque de précision. La qualité perçue, la réputation passe par là.

C’est vrai que cela représente un gros travail, mais c’est un travail qui a été négligé depuis trop longtemps.

L’image a toujours été négligée, que ce soit dans le graphisme ou dans la communication. Ceux qui n’ont pas fait cette erreur ont réussi à percer (Mozilla, Google ((don’t be evil, quel formidable slogan, un logo travaillé, une page épurée. Ensuite seulement viennent les résultats.)), Ubuntu, Apple ((dont tous les produits sont basés sur l’image avant les aspects techniques)), même Microsoft accorde une importance primordiale sur ces points). Les campagnes publicitaires ou de mises en avant se retrouvent réduite à néant à cause des mauvais articles des utilisateurs. Pourquoi pensez vous que les plus grand xxxxx ((mettez ici ce que vous voulez)) censurent leurs forums et font des procès aux détracteurs? Sans aller jusque là, une attention particulière est nécessaire de la part du libre pour continuer d’exister la tête haute.

Pour l’histoire

Je teste beaucoup de distributions. Les bonnes idées sont à prendre où elles sont, et les logiciels libres sont un creuset où chacun peut faire sa cuisine. J’ai voulu tester une distribution non confidentielle dont je tairais le nom, dont on m’avait venté les outils d’administration. Même en parlant 3 langues, en en lisant deux autres et avec le traducteur de Google, j’ai passé un temps fou à trouver les informations minimales sur les logiciels intégrés.

Si j’avais vraiment voulu basculer sur cette distribution, j’aurais fait bien vite demi tour! Cette distribution n’était pas faite pour moi, selon certains. Peut être. Peut être aussi qu’elle n’est faite pour personne et que le problème se règlera de lui même, lorsque sa communauté aura fini de se saborder…

PS: cet article a été écrit il y a quelques jours et seulement publié aujourd’hui. Que les auteurs dont les billets me précèdent ne voient pas d’attaque envers leur article.

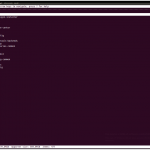

J’ai eu besoin d’utiliser un ordinateur en tant que serveur (DHCP et fichiers) sur un réseau et, pour diverses raisons, j’ai préféré utiliser un ordinateur portable pour rendre ces services.

J’ai eu besoin d’utiliser un ordinateur en tant que serveur (DHCP et fichiers) sur un réseau et, pour diverses raisons, j’ai préféré utiliser un ordinateur portable pour rendre ces services.

Je ne vais pas vous réexpliquer

Je ne vais pas vous réexpliquer